HPC

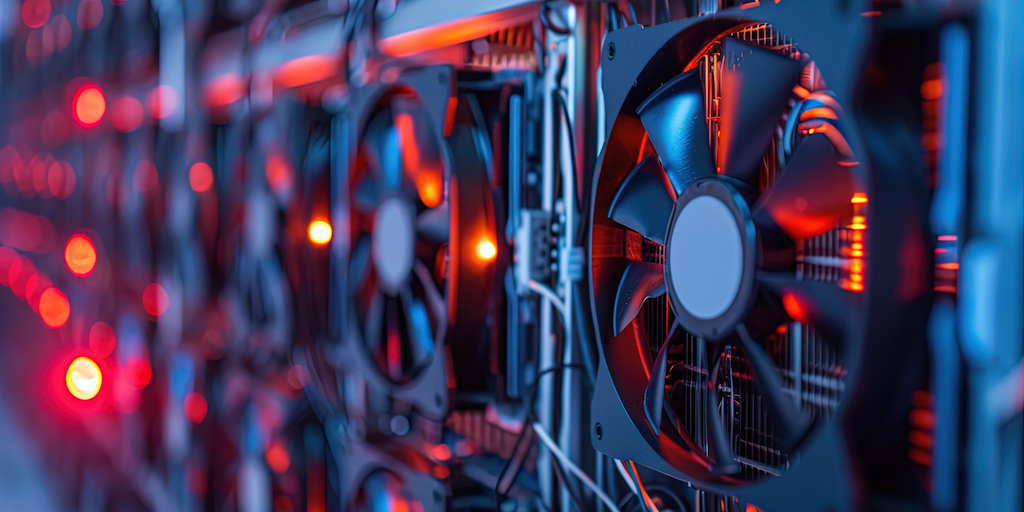

La computación de alto rendimiento es una tecnología que utiliza clústeres de potentes procesadores que trabajan en paralelo para el procesamiento de sistemas de IA.

HPC (Computación de Alto Rendimiento)

La computación de alto rendimiento (HPC) es en una metodología de agregar recursos de procesamiento para obtener un rendimiento mayor que el de solo una maquina. El HPC puede tomar la forma de supercomputadora o grupo de computadoras en clúster. El HPC puede ser en entornos locales, en la nube o híbridos de ambas. Cada computadora del conjunto es un nodo y cada uno tiene una tarea diferente. Los nodos de controlador ejecuta servicios esenciales y coordinan el trabajo entre nodos. Los nodos interactivos son los que permiten el acceso de los usuarios mediante una interfaz de tipo grafica (GUI) o de comandos de línea (CLI). Los nodos de procesamiento o nodos de trabajo ejecutan las tareas de procesamiento. Los algoritmos y el software se ejecutan en paralelo en cada nodo del clúster para ayudar a realizar su tarea determinada. El HPC suele tener a lo menos tres componentes principales. Procesamiento, Almacenamiento y Redes.

EL HPC permite que las empresas e investigadores puedan agregar recursos de procesamiento afín de que puedan resolver problemas que son demasiado complejos para ser resueltos por una sola computadora estándar o que tardarían demasiado tiempo en procesarlo. Por esto a menudo suele llamarse supercomputación.

Algunos ejemplos en los cuales se puede utilizar HPC. Resolver problemas en investigación académica, diseño, la simulación, inteligencia empresarial, y mas. La capacidad de HPC para procesa rápidamente grandes volúmenes de datos es uno de los recursos mas requeridos en la actualidad, como ejemplo la detección de fraudes de tarjetas de crédito, las simulaciones de procesos industriales, verificación de seguridad en la fabricación de vehículos, simulación de la predicción del tiempo, entre otros.

HPC permite resolver actualmente algunos de los problemas informáticos mas complejos en tiempo real, mediante el procesamiento de conjuntos de datos multidimensionales masivos, conocidos como Big Data.

Tecnologías de Agrupación HPC

Como se comento anteriormente HPC tiene tres componentes principales: Procesamiento, Almacenamiento y Redes. En términos simples los nodos de procesamiento del sistema HPC se conectan con otros nodos para ejecutar algoritmos y aplicaciones simultáneamente, luego mediante servicios de red se conectan con servidores de datos para capturar la salida. HPC se puede implementar en dos tipos de diseño generales. Computación de Clúster y Computación Distribuida.

Computación de Clúster. Se enfoca en la agrupación de múltiples computadoras para que trabajen juntas como un sistema, compartiendo recursos y datos, mejorando el rendimiento. disponibilidad y escalabilidad. Esta configuración las computadoras del clúster suelen estar físicamente juntas y conectadas a una red local. El software de clúster gestiona la coordinación y el uso de los recursos. Los clúster son comúnmente utilizados en entornos de computación de alto rendimiento y para aplicaciones que requieren alta disponibilidad, procesamiento de Big Data, clúster de servidores web, y otros.

Computación Distribuida. Se refiere a la distribución de tareas entre múltiples computadoras en una red permitiendo que trabajen de forma independiente o coordinada. Aprovechan los recursos computacionales de forma mas eficiente, mejora la escalabilidad y la tolerancia a fallas. Las computadoras en una red distribuida pueden estar en diferentes ubicaciones físicas. La comunicación entre las computadoras pueden ser a través de redes locales, internet o tecnologías de red inalámbrica. Estas configuraciones pueden ser utilizadas para diversas aplicaciones, como nube y sistemas de procesamiento de datos en masa, sistemas de recomendación, procesamiento de imágenes, y mas.

En resumen la computación en clúster es una forma especifica de computación distribuida que se centra en la agrupación de computadoras para un objetivo común. La computación distribuida es un concepto mas amplio que abarca la distribución de tareas y datos entre múltiples computadoras en una red, no importando su ubicación física o como se coordinan.

Cargas de Trabajo en HPC

Las cargas de trabajo en HPC son tareas informáticas que requieren un alto rendimiento. Como las simulaciones complejas, cálculos matemáticos intensivos, o procesamiento de grandes volúmenes de datos. Las cargas de trabajo en un entorno HPC se divide en dos tipos: Con acoplamiento bajo y con acoplamiento alto.

Con acoplamiento bajo. Son cargas de trabajos paralelos o de alta capacidad de procesamiento. Estas tareas son independientes y que se pueden ejecutar al mismo tiempo en el sistema. Podría ser que se comparta un almacenamiento común, pero no dependen del contexto por ello no necesitan comunicar resultados entre si a medida que se completan. Como ejemplo el renderizado de imágenes generadas por computadora (CGI) en un largometraje.

Con acoplamiento alto. Consiste de pequeños procesos, cada uno controlado por diferentes nodos en un clúster que dependen uno del otro para completar la tarea general. En general la cargas de trabajo con alto acoplamiento requieren herramientas de redes de baja latencia entre los nodos y un acceso rápido a la memoria y almacenamiento compartido. La comunicación entre procesos para estas cargas de trabajo se manejan mediante una interfaz de transmisión de mensajes (MPI) con software como Intel MPI y OpenMPI. Como ejemplo el pronostico del tiempo, que involucra una simulación basada en la física de sistemas dinámicos e interdependientes que involucran la temperatura, el viento, la presión, las precipitaciones y mas. Aquí cada nodo del clúster puede procesar soluciones parciales para diferentes factores climáticos para contribuir al pronostico general.

Las cargas de trabajo suelen utilizar recursos computacionales masivos para resolver problemas en áreas como ciencia, ingeniería y negocios.

Para Tareas complejas. Estas requieren cálculos que demandan una gran potencia computacional.

Para Procesamiento intensivo. Por lo general requieren grandes cantidades de memoria y tiempo de procesamiento.

Para Escalabilidad. Pueden ser ejecutadas en sistemas computacionales escalables y se puede agregar mas recursos según sea necesario.

Algunos ejemplos de cargas de trabajo en HPC pueden ser. Simulaciones de clima (predicciones meteorológicas), Diseño de productos (simulación de estructuras, análisis de materiales), Análisis financiero (evaluación de carteras, modelo de riesgo), Investigación científica (análisis de datos biológicos, desarrollo de nuevos medicamentos), Aprendizaje automático (entrenamiento de modelos complejos), entre otros.

Algunas características de las cargas de trabajo en HPC. Escalabilidad (sistemas computacionales que se pueden escalar vertical y horizontalmente). Alto rendimiento (Alta capacidad de procesamiento y almacenamiento), Distribución de datos (distribución en múltiples nodos o dispositivos de almacenamiento), Paralelismo (ejecución de trabajo en paralelo utilizando múltiples núcleos de CPU o GPU), Optimización (ejecución de trabajo para usar el máximo de los recursos computacionales) y mas.

Casos de Uso de HPC

Las aplicaciones de HPC en general se refieren a aplicaciones de IA, aprendizaje automático y aprendizaje profundo. Los sistemas HPC se crean teniendo en cuenta estas cargas de trabajo y por ello las aplicaciones de HPC están impulsando la innovación continua en algunas áreas como:

Salud, genómica y ciencias de la vida. El primer intento de secuenciar un genoma humano duro 13 años, hoy en día los sistemas HPC pueden hacer el trabajo en menos de un día. Otras aplicaciones de HPC en el cuidado de la salud y las ciencias de la vida incluyen el descubrimiento y diseño de fármacos, el diagnostico rápido del cáncer y el modelado molecular.

Servicios financieros. Adicional a la negociación automatizada y la detección de fraudes, el HPC impulsa las aplicaciones de simulación Monte Carlo y otros métodos de análisis de riesgos.

Gobierno y defensa. Dos casos de uso cada vez mas frecuentes de HPC en este ámbito es la predicción meteorológica y l a modelación del clima, el cual implica el procesamiento de grandes volúmenes de datos meteorológicos históricos y millones de cambios diarios en puntos de datos relacionados con el clima. Otras aplicaciones de gobierno y de defensa incluyen la investigación energética y el trabajo de inteligencia.

Energía. Para algunos casos donde se superponen con el gobierno y la defensa, las aplicaciones de HPC relacionadas con la energía incluyen el procesamiento de datos sísmicos, simulación y modelado de yacimientos, análisis geoespacial, simulación del viento y mapeo del terreno.

HPC en Nube. Hoy las nubes de diversos proveedores ofrecen el servicio de alto rendimiento en nube, tanto si la carga de trabajo requiere un entorno de nube hibrida o uno contenido en nube, a veces denominada HPC como servició o HPCaaS, ofrece a las organizaciones una forma rápida y escalable de aprovechar las ventajas del HPC. Este servicio puede incluir acceso a clústeres HPC e infraestructura alojada en el centro de datos de un proveedor de servicios de la nube.

Beneficios e Importancia de HPC

Algunos beneficios de utilizar cargas de trabajo en HPC son:

Rapidez. Permite acelerar el tiempo de resolución, obtener soluciones mas rápido para las tareas donde el tiempo es critico.

Mejor precisión. Las simulaciones y cálculos complejos pueden ser precisos con mayor poder computacional.

Ahorro de costos. Las cargas de trabajo de HPC en la nube pueden permitir a las organizaciones pagar solo los recursos que utilizan, lo que podría ayudar a reducir costos.

Escalabilidad. Este es un beneficio que facilita la expansión de las capacidades y desarrollo de computo según sea necesario.

Colaboración. Permite a equipos de investigación y desarrollo trabajar juntos en proyectos complejos.

Velocidad y rendimiento. El HPC puede procesar datos y tareas mucho mas rápido que un servidor. Las tareas que pueden tardar semanas o meses en un sistema de procesamiento estándar puede tardar horas en un HPC.

Flexibilidad y eficiencia. Con HPC en la nube se pude aumentar o reducir verticalmente la escala de las cargas de trabajo según las necesidades. También mediante una solida conexión a internet se puede acceder de cualquier lugar.

Tolerancia a errores. Si un nodo del clúster de HPC falla el sistema es lo suficientemente resiliente como para que el sistema no falle. Dada las grandes tareas y su complejidad ejecutadas en HPC, la tolerancia a fallas es una gran ventaja.

I+D acelerado. El HPC brinda una ventaja a las organizaciones en la investigación y desarrollo, acelerando los resultados de proyectos que consumen muchos datos, como el diseño de maquinarias o simulación para reducir las pruebas físicas.

Importancia de HPC. El ecosistema moderno esta inundado de datos y herramientas de procesamiento intensivo para su análisis. Es aquí donde el HPC tiene su relevancia permitiendo que las organizaciones procesen todos este gran volumen de datos de una manera oportuna, para impulsar la innovación, nuevos hallazgos, estadísticas, y descubrimientos científicos. De esta manera las empresas pueden prever situaciones comerciales, predecir fluctuaciones del mercado y hacer recomendaciones. El en campo de la medicina los ayuda a modelar posibles brotes, decodificar el genoma de las células cancerosas y comprender como evolucionan las enfermedades.

En definitiva el HPC acelera el ritmo de avance científico, tecnológico y empresarial, lo cual permite ayudar a la humanidad en su desarrollo y a crear un futuro más próspero.

Para servicios integrales de computación de alto rendimiento (HPC) en entornos empresariales productivos o en desarrollo contamos con el know-how de esta tecnología para ayudar en su implementación en el negocio. Contáctanos en INOVAS